[Wang_Simoncelli_Bovik_2003]

Multi-Scale Structural Similarity for Image Quality Assessment

Resumen:

El paper propone un método multi-escala (multi-resolución) de "Structural Similarity" que proporciona más flexibilidad que el método single-scale al incorporar variaciones de las condiciones de visualización. Desarrollan un método de síntesis de imágenes para calibrar los parámetros que definen la importancia relativa de las diferentes escalas.

A pesar que el método de escala única (o de única resolución) propuesto en Wang_Bovik_Sheikh_Simoncelli_2004 mejora las métricas de calidad existentes en el estado del arte (hasta la fecha del paper se entiende) comentan que una deficiencia de dicho método es que no es sensible a las condiciones de visualización de las imágenes porque la escala apropiada dependerá de la resolución del display y la distancia de visualización. Proponen una métrica de similitud estructural multiescala que introduce sintesis de imágenes como aproximación para la calibración de los parametros que rigen la importancia relativa entre las diferentes escalas.

La percepción de los detalles de las imágenes depende de la densidad de muestreo de la imagen, la distancia desde el plano de la imagen al observador y de la capacidad perceptual de éste. En la práctica la percepción subjetiva de las imágenes varia cuando estos factores lo hacen. El método single-scale es apropiado solo para unas condiciones de visualización determinadas. Con el método multiescala pretenden evaluar distintos detalles a diferentes resoluciones.

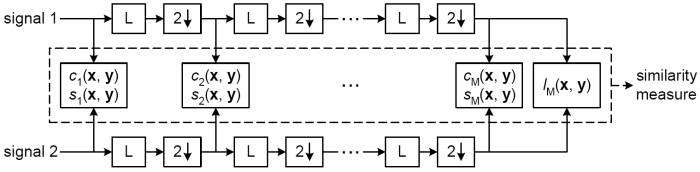

La imagen de referencia y la distorsionada son las entradas. Se realiza la comparación de contrastes y de estructura (revisar Wang_Bovik_Simoncelli_2005), seguido de un filtrado low-pass y un downsampling por un factor de 2, tras el cual se vuelve a realizar las comparaciones de contraste y estructura. Así para cada uno de las escalas definidas, excepto para la última que es la única tras la cual se realiza la comparación de luminancia. La métrica final se obtiene por combinación de las medidas en las diferentes escalas con:

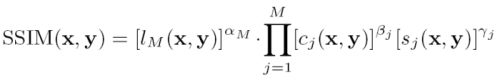

donde los parametros alpha, beta y gamma se utilizan para ajustar la importancia relativa de las diferentes distorsiones (luminancia, contraste y estructura).

La diferencia respecto al modelo sigle-scale es que para cada escala hay que determinar estos parámetros. Conceptualmente esto debería poder realizarse mediante la CSF (Contrast Sensitivity Function) del HVS (Human Visual System) que establece que la sensibilidad humana tiene un pico a frecuencias medias (cercanas a 4 cpd de angulo visual) y decrece a lo largo de las direcciones de altas y bajas frecuencias. Pero no puede ser usada aqui porque normalmente se mide (la CSF) en el umbral de visibilidad utilizando estímulos simples como sinusoidales, y el proposito del trabajo es comparar imágnes complejas altamente estructuradas (imagenes naturales) a diferentes niveles visibles de distorsión.

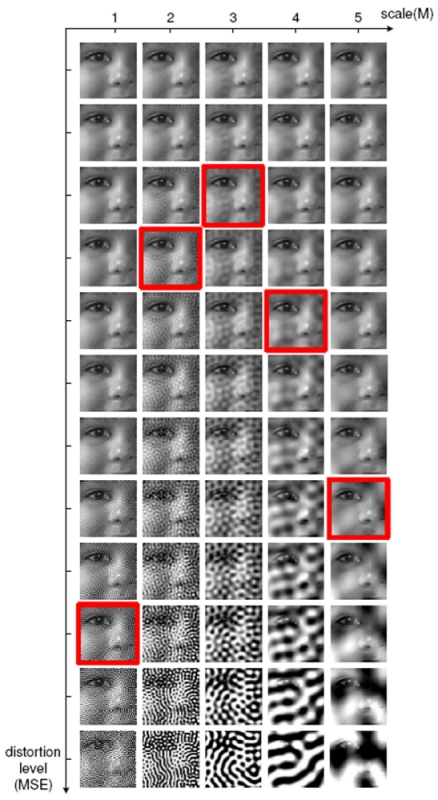

Por tanto, para calibrar los parámetros de cada escala, lo que han realizado es un generador (sintetizador) de imágenes para distintos niveles de MSE y diferentes escalas. Es decir, fijando un nivel de calidad MSE generan tantas escalas como establezcan degenerando la imágen inicial añadiendo ruido gausiano en un proceso iterativo que utiliza un algoritmo de descenso de gradiente para alcanzar la medida de variación. Al final tienen una matriz de imágenes cuyas filas son diferentes niveles de MSE y sus columnas diferentes niveles de distorsión de forma que se mantenga en la misma fila (para cada columna) el mismo valor MSE. Estas matrices de imágenes se muestran a los observadores humanos a una distancia fijada a 32 pixels/grado de angulo visual. Los sujetos tienen que marcar para cada columna una imagen de forma que la calidad percibida en todas ellas a esa distancia sea la misma. Al final se median los valores de todos los observadores y se fijan los parámetros para cada escala (ver paper).

Han realizado test con las imágenes de la base de datos LIVE con JPEG y JPEG2000. La tasa de bits varia de 0.028 a 3.150 bits/pixel para cubrir un amplio rango de imágenes. El (Mean Opinion Score) (MOS) de cada imagen se realizo entre 13 y 25 sujetos. Han comparado 8 modelos de calidad de imagen, PSNR, Sarnoff (JNDmetrix 8.0), single-scale SSIM con indices de 1 a 5 y la multi-scale SSIM (la propuesta).

Los resultados, ver paper, indican que el modelo propuesto supera a todas los demás modelos, incluyendo el mejor de los SSIM single-scale sugiriendo un significativo balance entre escalas.

En el desarrollo de modelos de calidad de imagen top-down, como los algoritmos basados en la Similitud Estructural, uno de los problemas más grandes es ajustar los parámetros del modelo (que suelen ser bastante abstractors) para que el modelo se correlacione bien con la evaluación subjetiva. Estos parámetros no son directamente obtenidos a partir de experimentos subjetivos como en los modelos bottom-up. Han desarrollado un sintetizador de imágenes para poder calibrar los parámetros que definen la importancia relativa entre las distintas escalas.

Bibliografía disponible:

[]

[]